Šta su parametri kod velikih jezičkih modela (LLM)?

Nedelja, 2. novembar 2025. 02:02

Autor: Dragan Tanaskoski

Tagovi: temperatura

Parametar kod velikih jezičkih modela (LLM) je jedna od ključnih komponenti koja kontroliše rad i ponašanje modela. Veliki jezički modeli su napredne neuronske mreže sa milijardama parametara – numeričkih vrednosti (težina i pristrasnosti) naučenih tokom procesa obuke na ogromnim količinama tekstualnih podataka. Ti parametri omogućavaju modelu da prepozna složene obrasce u jeziku i da generiše koherentan, smislen tekst.

Dva tipa parametara

Kada govorimo o parametrima u kontekstu LLM-ova, razlikujemo dva osnovna tipa:

1. Parametri modela (težine i pristrasnosti)

Ovo su unutrašnje kvantitativne vrednosti koje definišu samu strukturu, funkcionalnost i sposobnosti modela. Tokom procesa obuke, model "uči" optimalne vrednosti ovih parametara analizirajući ogromne količine teksta. Što je broj parametara veći, model generalno može biti kompleksniji i precizniji u razumevanju konteksta, nijansiranju značenja i generisanju prirodnog jezika.

Na primer:

- GPT-2 ima oko 1,5 milijardi parametara

- GPT-3 ima 175 milijardi parametara

- Najnoviji modeli poput GPT-4, Claude ili Llama 3 imaju stotine milijardi, pa čak i preko bilion parametara

Međutim, važno je napomenuti da broj parametara nije jedini pokazatelj kvaliteta modela. Arhitektura mreže, kvalitet podataka za obuku, tehnike fine-tuninga i optimizacije takođe igraju krucijalnu ulogu u performansama modela.

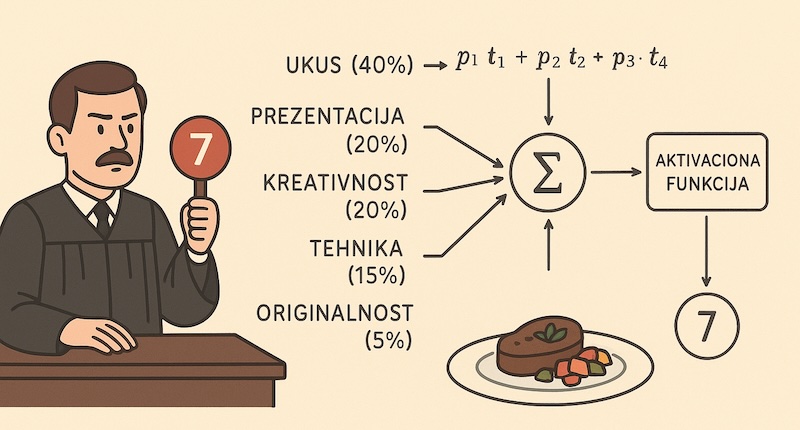

(Primer preuzet iz knjige: Veštačka inteligencija: Osnove i uvod u rad, Mikro knjiga, 2025.)

(Primer preuzet iz knjige: Veštačka inteligencija: Osnove i uvod u rad, Mikro knjiga, 2025.)

2. Korisnički parametri (hyperparametri za generisanje)

Pored parametara modela, postoje i korisnička podešavanja koja kontrolišu način na koji model generiše tekst. Ovi parametri omogućavaju fine-tuning izlaza prema specifičnim potrebama:

-

Temperature (temperatura): Kontroliše kreativnost iRandomness izlaza. Niže vrednosti (0.1-0.5) daju predvidljivije, konzistentnije odgovore, dok više vrednosti (0.8-1.5) podstiču kreativnost i raznovrsnost.

-

Top-k: Ograničava model da bira samo između k najvernijih sledećih tokena, čime se smanjuje verovatnoća generisanja besmislenih odgovora.

-

Top-p (nucleus sampling): Bira najmanju grupu najvernijih tokena čija kumulativna verovatnoća dostiže p, omogućavajući dinamičniji izbor.

-

Max tokens (maksimalna dužina): Određuje maksimalnu dužinu generisanog teksta.

-

Frequency/Presence penalty: Kontrolišu ponavljanje reči i fraza u odgovoru.

Zašto su parametri važni?

Parametri su "mozak" velikih jezičkih modela. Njihova količina i kvalitet direktno utiču na:

- Razumevanje konteksta i semantike jezika

- Sposobnost rezonovanja i logičkog zaključivanja

- Preciznost u specifičnim domenima (medicini, pravu, programiranju)

- Multilingvalnu kompetenciju

- Generalizaciju znanja na nove situacije

Zaključak

Ukratko, parametri u velikim jezičkim modelima su ključne numeričke vrednosti koje model koristi za funkcionisanje, učenje i generisanje jezika. Razumevanje razlike između parametara modela i korisničkih parametara omogućava bolje korišćenje i optimizaciju LLM-ova za različite primene – od chatbotova i virtuelnih asistenata do alata za pisanje, prevođenje i analizu podataka.

Izvori:

Komentari

Nema komentara. Šta vi mislite o ovome?