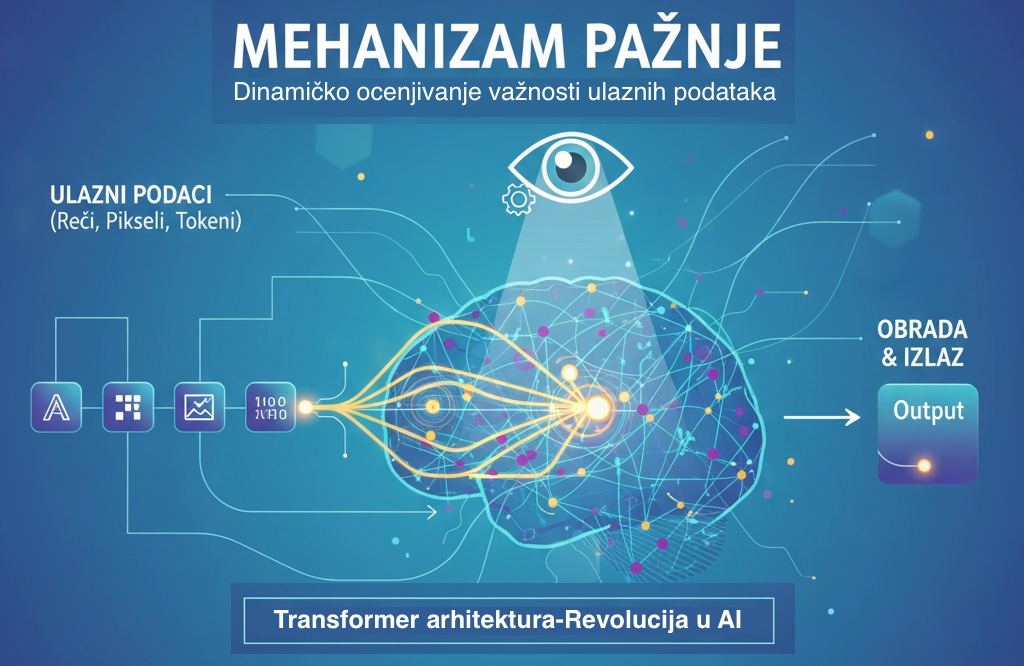

Šta je mehanizam pažnje (Attention Mechanism)?

Sreda, 19. novembar 2025. 18:00

Autor: Dragan Tanaskoski

Tagovi: Pažnja, Transformer

Mehanizam pažnje je tehnika koja omogućava neuronskoj mreži da dinamički proceni važnost različitih delova ulaznih podataka (reči, piksela ili tokena) prilikom obrade svakog pojedinačnog dela. Ova tehnika, koja leži u arhitekturi Transformer modela, je revolucionisala AI,

Umesto da tretira sve reči u rečenici jednako (kao što su radili raniji modeli RNN i LSTM), pažnja omogućava modelu da:

- Fokusira se: Odredi koji su delovi ulaza najrelevantniji za trenutnu akciju (npr. prevođenje trenutne reči, generisanje sledećeg tokena).

- Poveže udaljeno: Uhvati zavisnosti između reči koje su međusobno udaljene u rečenici (tzv. long-range dependencies).

Konceptualno: Zamislite čoveka koji čita dugu rečenicu. Kada naiđe na zamenicu ("ono", "ona"), njegova pažnja se automatski vraća na relevantnu imenicu koja je ranije pomenuta, kako bi razumeo na šta se zamenica odnosi. Mehanizam pažnje radi istu stvar u digitalnom domenu.

Kako funkcioniše samopažnja (Self-Attention)?

U srcu Transformer modela nalazi se Samopažnja (Self-Attention). Ova specifična vrsta pažnje omogućava modelu da analizira odnose unutar istog niza (npr. rečenice).

Proces se matematički svodi na tri vektora izvedena iz svakog ulaznog tokena:

- Upit (Query, Q): Predstavlja "šta tražim" za trenutni token.

- Ključ (Key, K): Predstavlja "šta imam" za svaki drugi token u nizu.

- Vrednost (Value, V): Predstavlja stvarni sadržaj tokena koji će biti prenet.

Koraci u samopažnji:

- Računanje Rezultata (Scores): Računa se skalarni proizvod Q (trenutnog tokena) sa svim K (svih ostalih tokena). Viši rezultat znači veću relevantnost.

- Normalizacija (Softmax): Rezultati se skaliraju i normalizuju pomoću Softmax funkcije, pretvarajući ih u distribuciju težina (pažnje), gde je zbir svih težina jednak 1.

- Kreiranje Izlaza: Svaka V vrednost se množi sa odgovarajućom težinom pažnje. Zbir ovih ponderisanih vrednosti V postaje izlazni vektor za trenutni token.

Primer: U rečenici "Banka je poplavila jer je pukla cev u njoj."

Kada model obrađuje token "njoj", mehanizam pažnje izračunava visoku težinu između "njoj" i "Banka" (iako su daleko), čime osigurava da je kontekst precizno prenet, za razliku od "Cev".

🔑 Značaj i uticaj pažnje

Uvođenje mehanizma pažnje, a posebno Self-Attention u Transformer arhitekturu 2017. godine, dovelo je do dve ključne prednosti koje su omogućile stvaranje modernih LLM-ova:

1. Paralelizacija

Za razliku od sekvencijalnih (korak-po-korak) modela, pažnja omogućava Transformerima da obrađuju sve tokene u nizu istovremeno. Ovo je ključno za efikasno korišćenje modernog hardvera (GPU/TPU) i omogućilo je obuku na masivnim setovima podataka.

2. Nezavisnost od udaljenosti

Modeli pažnje mogu direktno povezati dva tokena, bez obzira da li su susedi ili su udaljeni hiljadu tokena. Ovo je od suštinskog značaja za razumevanje dugačkih dokumenata, kompleksnih gramatičkih struktura i konzistentnost dugih AI generisanih tekstova.

Budućnost pažnje: Od Multi-Head do Query-Key pažnje

Moderne implementacije koriste Multi-Head Attention – gde model istovremeno koristi više nezavisnih "glava" pažnje. Svaka glava se fokusira na različite tipove odnosa u podacima, čime se poboljšava sveobuhvatno razumevanje.

Mehanizam pažnje nastavlja da se razvija (npr. Flash Attention, Grouped-Query Attention) sa ciljem da postane još brži i efikasniji, omogućavajući nam da obrađujemo kontekste koji su duži od 100.000 tokena.

Zaključak: Pažnja nije samo elegantna ideja; to je matematička formula koja je AI dala kontekstualni vid. Ona je mozak iza današnjih moćnih AI alata, od prevođenja do generisanja koda.

Komentari

Nema komentara. Šta vi mislite o ovome?